# 线性回归

# 逻辑回归

(用于解决分类问题)

要点:

①寻找决策边界的格式

②损失函数最小化情况下,求解决策边界的系数

分类问题

逻辑回归的简单解释:

sigmoid 函数(一种概率分布函数)S(x)=1+e−x1 ,图像如下:

其中 S(x) > 0.5 的视为 1, S(x) < 0.5 的视为 0,即可对所有的 x 进行分类。

![image-20240123162931645]()

概率分布函数

P(x)=1+e−g(x)1,其中 g(x)=0 为决策边界(Decision Boundary), sigmoid 函数就是g(x)=x 的情况。

(所以 P(x) 分类方法同 sigmoid 函数)

g(x)=θ0+θ1x1+… 为一般格式,可能为多元,包含高次项

损失函数

损失函数 J 即用于评估分类结果的函数。对于不正确的分类结果, J 越大越好;对于正确的分类结果, J 越小越好

因此有 单个样本的损失函数:Ji={−log(P(xi)),−log(1−P(xi)),yi=1yi=0

其中 yi 表示真实结果,P(xi) 为样本 xi 的概率分布(预测结果)。

为了在计算机中实现,可将 整体样本的损失函数 等效为:

J=m1i=1∑mJi=−m1[i=1∑m(yilog(P(xi))+(1−yi)log(1−P(xi)))]

回归问题求解

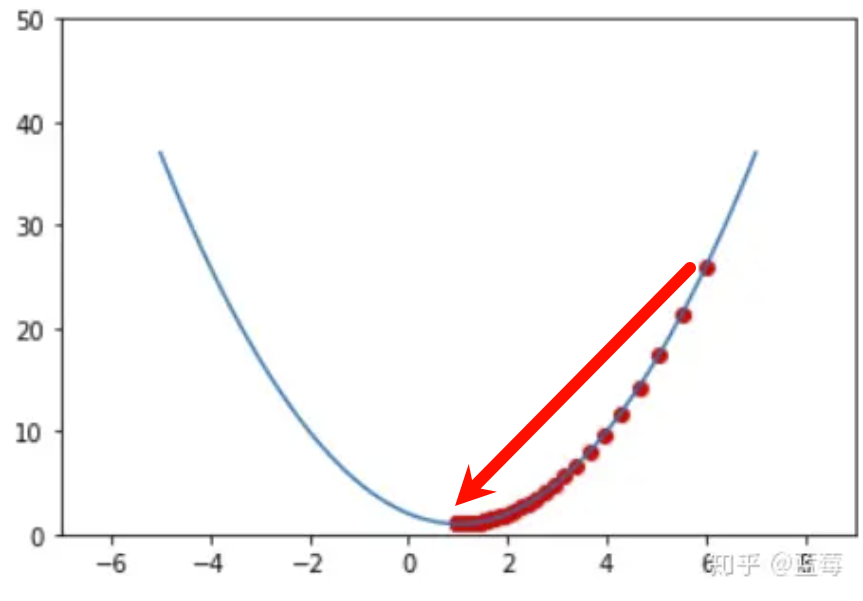

即最小化损失函数:使用梯度下降法,寻找 min(J) 情况下决策边界中 θi 的值。

θj+1=θj−α∂θj∂J(θ)

每次寻找都为:上一次的结果 + 梯度反方向 × 某一固定值α

实际上,每次寻找都会不断接近最优值。

![image-20240123171620499]()